Deepfake vs RGPD: ¿Tratamiento biométrico prohibido?

¿Generar un deepfake es un tratamiento biométrico que permite la identificación unívoca de la “víctima”? Yo digo sí.

Hoy me suelto la melena y afirmo que se puede sancionar un deepfake inconsentido, no sólo por falta de base legal (consentimiento) sino también por tratamiento biométrico prohibido.

¿Están locos estos romanos? Pues lo digo con apoyo en decisiones de autoridades de cumplimiento.

Pero empecemos por el principio:

Los deepfakes son outputs de imagen, vídeo o audio generados mediante inteligencia artificial que recrean de forma verosímil a personas reales.

En un momento en que los deepfakes están recibiendo máxima atención mediática y provocando anuncios de endurecimiento del régimen jurídico aplicable, examinamos la cuestión a la luz de la más reciente jurisprudencia y resoluciones de autoridades.

Durante febrero hemos visto lanzar un nuevo proyecto de ley reguladora del Derecho al honor intimidad y propia imagen recogiendo explícitamente al deepfake como intromisión ilegítima.

El jueves, sin ir más lejos se anunció la propuesta del Parlamento Europeo de incluir la generación de deepfakes sexuales no consentidos como nueva finalidad prohibida en el Reglamento de Inteligencia Artificial. Esta medida no arreglará mucho, por no decir nada, por razones que contamos aquí.

¿Todas las imágenes generadas con IA incumplen el RGPD?

Por supuesto que no.

Tenemos buenas razones para defender que los outputs de imagen, vídeo o audio que incluyan a personas físicas “random” generados por modelos de IA generativa no constituyen tratamiento de datos personales por defecto, salvo que:

(i) el modelo haya sido entrenado específicamente para incluir a personas identificadas en el output o

(ii) partan de un contenido como modelo y sean capaces de generar un output que se pueda confundir verosímilmente con dichas personas.

En el segundo caso, ya entraríamos en “territorio deepfake”.

Deepfake como tratamiento biométrico prohibido

Mi tesis es que un deepfake de los buenos, de los últimos, de los que son casi imposibles de distinguir de la realidad, son el resultado de un tratamiento biométrico de los prohibidos por el art. 9 del RGPD.

Sí, han leído bien. No, no me he vuelto loco.

Matizaciones:

· Por supuesto, el deepfake, debe incluir imagen fija, vídeo y/o voz de personas físicas.

· No me refiero al hecho de que representen a la persona clonada en circunstancias o disposición relacionada con una determinada orientación sexual, ideología política, dato de salud, etc… hablo aquí de “biometría”.

· No defiendo que la protección de datos personales sea la mejor vía, ni la única para atajar el problema, por ejemplo de los deepfakes sexuales inconsentidos. Lo que digo es que, IMHO, hoy en día es una vía, con una potencialidad sancionatoria inexplorada.

Como imagino que están poniendo caras raras, vamos al lío

Estás leyendo ZERO PARTY DATA. La newsletter sobre actualidad, tecnopolios y derecho de Jorge García Herrero y Darío López Rincón.

En los ratos libres que nos deja esta newsletter, estamos especializados en resolver movidas complicadas en protección de datos personales. Si tienes de alguna de esas, haznos así con la manita. O contáctanos por correo en jgh(arroba)jorgegarciaherrero.com

¡Gracias por leer Zero Party Data! Apúntate!

1 ¿Un deepfake es un dato personal?

Sin ninguna duda: Cuando un deepfake incluye el rostro, cuerpo, movimientos o la voz de una persona, su generación implica el tratamiento de sus datos personales en la medida en que el interesado resulte identificado o identificable.

Y ello aunque no se le identifique por identificadores directos (nombre, apellidos, cargo público, etc).

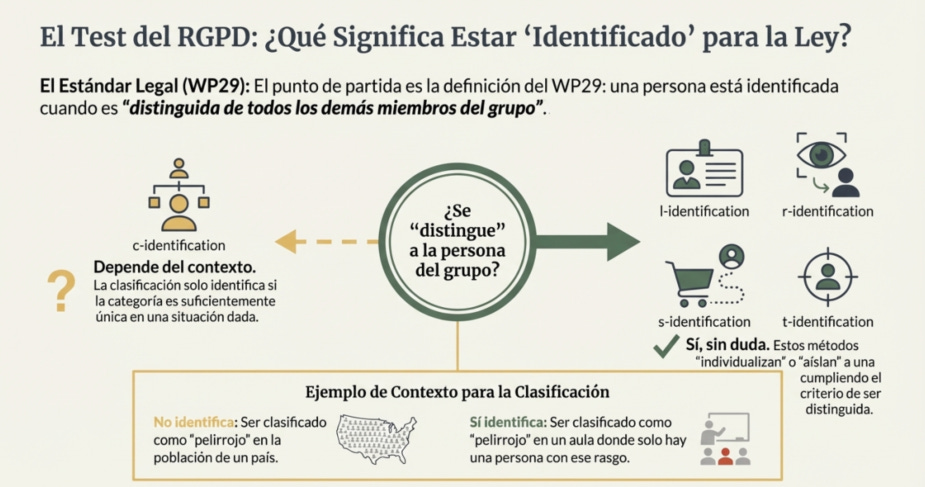

De acuerdo con la jurisprudencia del TJUE basta que el tratamiento permita que el interesado sea identificado o identificable o bien individualizable dentro de un grupo concreto de personas.

2 ¿La generación de un deepfake implica tratamiento de datos biométricos?

Advertencia: En este formato muggle-friendly les ahorro el grueso de los infumables rollos tecnológicos y jurídicos que me he tenido que tragar, y por tanto, renuncio a ser completamente riguroso a costa de ser comprensible.

La calificación de la generación de deepfakes como tratamiento biométrico prohibido por el RGPD depende de dos elementos:

a. La arquitectura tecnológica empleada por el sistema de IA generativa

b. Cómo se interprete el concepto de “identificación unívoca” del 9 RGPD.

2.1 Desde el punto de vista técnico:

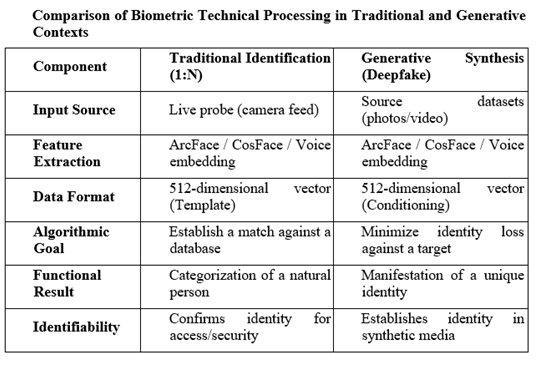

No tanto los sistemas de hace unos años, pero desde luego los sistemas modernos de generación de deepfakes de vídeo (Diffusion Transformers, modelos como Sora o Veo) extraen sistemáticamente características biométricas durante su funcionamiento

Mientras que en las arquitecturas tradicionales podía sostenerse que las representaciones latentes no constituían “plantillas biométricas” en sentido estricto, los sistemas modernos utilizan identity embeddings de modelos de reconocimiento facial funcionalmente equivalentes. Tanto los sistemas de reconocimiento facial (ArcFace, CosFace) como los sistemas de generación de deepfakes (y los de detección de deepfakes) utilizan una infraestructura técnica idéntica: vectores de embedding de 512 dimensiones que codifican características faciales únicas.

Por supuesto, en vídeo aunque las operaciones matemáticas son idénticas, la finaldiad funcional difiere:

· La identificación es análisis (imagen → decisión de identidad), mientras que

· El proceso de generación es inverso: síntesis (embedding de identidad → imagen).

Esto, sin embargo, no cuestiona que ambos procesos permiten la identificación unívoca de la persona objeto de un deepfake.

En el ámbito de identificación biométrica ortodoxa, se utilizan vectores como “plantillas” contra las que se comparan métricas de una persona para establecer su identidad.

En el de síntesis (generación) el modelo está realizando técnicamente un proceso continuo de “identificación” tanto durante la fase de entrenamiento como durante la de inferencia.

Al generador se le está ordenando esencialmente que genere una recreación que sería identificada de forma única como la persona objetivo por cualquier sistema de reconocimiento.

La integración de la finalidad de “coincidencia” en el propósito “generativo” es elocuente sobre la relevancia en ambos procesos de los datos que permiten una identificación única, satisfaciendo los criterios del Artículo 4.14 del RGPD.

Es decir, el tratamiento de datos biométricos es innegable.

Si hablamos de deepfakes de audio, la cuestión es aún más clara: implica un tratamiento biométrico susceptible de identificar al interesado y de hecho el tratamiento de voces de clientes con finalidad de identificación biométrica es cotidiano en el sector de la banca para evitar fraudes.

2.2 Desde el punto de vista jurídico, “identificación unívoca” se interpreta -de momento-, de otra manera

El concepto de “identificación unívoca” del interesado se ha entendido tradicionalmente como autenticación de identidad (1:1) o como identificación (1:n).

La cuestión -que defiendo- es si sería subsumible en el concepto de “identificación unívoca” del art. 9, el hecho de que al propio interesado le identifiquen (en el deepfake), no ya (i) el responsable del tratamiento -como en el caso de autenticación / identificación-, sino (ii) los terceros que vean, escuchen o tengan acceso al deepfake sintético:

· - El output-deepfake “se identifica” con el interesado.

· - Los terceros “identifican” al interesado de forma unívoca.

El Considerando 51 del RGPD establece que el tratamiento de fotografías no debe considerarse sistemáticamente tratamiento de categorías especiales, “pues únicamente se encuentran comprendidas en la definición de datos biométricos cuando el hecho de ser tratadas con medios técnicos específicos permita la identificación o la autenticación unívocas de una persona física”.

La interpretación ortodoxa o finalista -dominante hasta ahora- se centra en el propósito del tratamiento: si la finalidad no es identificar en un sistema (1:n), o autenticar (1:1) no se aprecia tratamiento biométrico del artículo 9.1.

Si se mantiene este criterio, los deepfakes —cuya finalidad es crear contenido sintético identificable con una persona, pero no verificar identidades— no activarían la prohibición del art. 9.

Y todo esto, sin entrar en:

.- La extracción previa de los datos biométricos de la imagen o vídeo originales del interesado -que se da sólo en algunos casos, de generación de vídeo- pero siempre en el de la voz-, para la generación del deepfake.

.- Como decía antes, el hecho de que el contenido y circunstancias del deepfake aludan a datos de categoría especial del interesado (da igual que sean veraces o falsos: de acuerdo con el TJUE siguen siendo datos personales).

2.3 ¿Qué ha dicho la AEPD?

Las autoridades de protección de datos apenas se han pronunciado sobre este tema.

De hecho, el primer caso fue la resolución de la AEPD sobre el caso Almendralejo.

En ella se impuso sanción por tratamiento de datos personales sin base legal (infracción del art. 6 RGPD) sin pronunciarse sobre la cuestión biométrica que aquí se postula.

Sin embargo, el antecedente parece poco representativo porque, a pesar de la gravedad de los hechos y de la alarma social y atención mediática del suceso, la multa fue moderada a la vista de la previa sanción penal y la situación económica de los progenitores que tuvieron que apechugar con las consecuencias civiles de la conducta del menor denunciado.

2.4 La jurisprudencia del TJUE:

De acuerdo con la jurisprudencia del TJUE:

· La protección reforzada de los datos sensibles exige una interpretación extensiva de éstos, (y ello en garantía de la protección de un derecho fundamental -el de protección de datos personales- pero hay que pensar que en un deepfake sexual, probablemente concurrirán otros adicionales).

Una manifestación elocuente de esta interpretación extensiva fue la inclusión del tratamiento de autenticación (1:1) como tratamiento biométrico prohibido al igual que la identificación, después de no pocas idas y venidas doctrinales y de las autoridades nacionales.

· Aunque los datos que se publiquen sobre tu vida u orientación sexual sean falsos, todavía son “datos sensibles” (categoría especial).

· Basta que de unos datos “se pueda inferir” información sensible, para considerarlos datos de categoría especial, y ello independientemente de que esa sea la finalidad del responsable o incluso de que la inferencia sea o no 100% exacta.

De acuerdo con lo anterior, podría hablarse de identificación unívoca del interesado en el “output deepfake”:

· …si la tecnología involucrada es la misma, y

· …si la misma tecnología permite no sólo que el Responsable identifique al interesado (1:n) sino que el interesado sea identificado por “tó Cristo” con acceso al deepfake.

Es decir, si el resultado del tratamiento permite la identificación unívoca del interesado -entendida como que cualquier tercero observador identifique inequívocamente a la persona suplantada, el tratamiento podría entenderse como tratamiento biométrico prohibido-.

2.5 La “advertencia” del Garante italiano.

El Garante italiano ha sido la primera autoridad europea en admitir (más aún: advertir) expresamente en diciembre de 2025 una interpretación amplia de “tratamiento biométrico prohibido”, publicando una “advertencia” en el sentido de que los deepfakes podrían constituir tratamiento de datos biométricos cuando el resultado permita la identificación de la persona suplantada ante terceros, con independencia de que el sistema no opere como verificador de identidad tradicional.

“CONSIDERANDO que la voz y las imágenes pueden, ciertamente, incluirse entre los denominados identificadores, es decir, aquella categoría de información que tiene una relación directa con la persona identificada y que, por lo tanto, dicho identificador vocal o visual puede clasificarse en la categoría de datos biométricos si se cumplen ciertos criterios específicos. Estos consisten en la naturaleza del dato, que debe referirse a una característica física, fisiológica o comportamental de una persona, y en los medios y finalidades del tratamiento realizado que deben consistir en un tratamiento técnico con el fin de una identificación unívoca; en este caso, es, por lo tanto, necesario no solo verificar la existencia de una base jurídica de conformidad con el art. 6 del RGPD, sino también de una de las condiciones indicadas en el art. 9.2 del RGPD. Condición necesaria también en el caso de que la voz pueda incluirse en el ámbito de las categorías especiales de datos.”

(…)

“POR TODO LO ANTERIORMENTE EXPUESTO, EL GARANTE:

a) de conformidad con el art. 58, párr. 2, letra a), del Reglamento, advierte a todas las personas físicas o jurídicas que utilicen, en calidad de responsables o encargados del tratamiento, servicios de generación de contenidos basados en inteligencia artificial a partir de voces o imágenes reales de terceros, que dicho tratamiento de datos personales, si se realiza en ausencia de una condición de licitud adecuada y sin que se proporcione previamente a los interesados información correcta y transparente, puede, verosímilmente, infringir las disposiciones del Reglamento, en particular los arts. 5, párr. 1, letra a), 6 y 9 del Reglamento, con todas las consecuencias, incluso de carácter sancionador, previstas por la normativa en materia de protección de datos personales;

b) de conformidad con el art. 154-bis, apartado 3, del Código, dispone la publicación en la Gaceta Oficial de la República Italiana.”

Si se leen el doc entero, comprobarán que se dirige no sólo a los usuarios, sino también a las plataformas que ponen los medios de generación de deepfakes a disposición de aquellos.

3 Antecedentes en Derecho comparado

3.1 BIPA en Illinois (USA)

De acuerdo con la Illinois Biometric Information Privacy Act (“BIPA”) el concepto de “biometric identifier” incluye explícitamente “scan of hand or face geometry”, término que describe precisamente el proceso técnico de extracción de embeddings faciales.

La distinción crítica es que mientras las fotografías están excluidas de la definición de identificadores biométricos, los scans de geometría facial derivados de fotografías no lo están. Meta transó un “acuerdo sancionatorio” de $650 millones por extraer la geometría facial de fotos subidas a Facebook por sus usuarios (lo que constituye recolección de identificadores biométricos bajo BIPA) sin su consentimiento.

La Fiscal General de Illinois publicó en febrero 2025 una carta abierta sobre modelos de Gen-AI (específicamente Grok), señalando preocupación de que “the AI model may be scraping biometric data, in violation of BIPA, to create its deepfake images.”

Adicionalmente, servicios de face-swap como SwapFaces AI ya se promocionan como “BIPA Compliant”, asumiendo implícitamente la aplicabilidad de la ley.

3.2 La regulación china es aún más clara

Las Disposiciones sobre la Administración de Servicios de Síntesis Profunda (vigentes desde enero 2023) regulan explícitamente la generación y edición de características biométricas en deepfakes.

El Artículo 14 establece que los proveedores de servicios de síntesis profunda que ofrezcan funciones de edición de información biométrica facial o vocal “deben solicitar a los usuarios que notifiquen a la persona cuya información personal está siendo editada y obtengan su consentimiento independiente“

El Artículo 23(4) define síntesis profunda para incluir “tecnologías para generar o editar características biométricas en contenido de imagen y video, tales como generación de rostros, intercambio de rostros, edición de atributos personales, manipulación facial o manipulación de gestos.”

Por tanto, y a diferencia del RGPD, la PIPL china no condiciona la calificación de datos biométricos a la finalidad de identificación única —la clasificación se basa en el potencial de daño, no en el propósito del tratamiento.

3.3 Brasil

Brasil (país recién declarado adecuado al RGPD) publicó hace pocos días en relación con el caso Grok, la Nota Técnica 1/2026 de la ANPD, que establece que

“el contenido sintético generado por sistemas de IA generativa, cuando se refiera a personas naturales identificadas o identificables, debe considerarse datos personales“

y que:

“cuando tal actividad implique el uso de datos biométricos, el contenido sintético resultante asumirá la calificación de datos personales sensibles. “

4 ¿Qué efecto sancionatorio tendría mi interpretación?

Dependiendo de las circunstancias del concreto deepfake, se podrían apreciar dos, tres, cuatro… infracciones de la prohibición de tratamiento de datos de categoría especial.

El RGPD no permite acumular el número de infracciones apreciadas en estos casos, pero sí sancionar la infracción más grave en su nivel más alto. Y todos sabemos lo altas que pueden llegar a ser las sanciones del RGPD.

Aquí sí, las espadas están en todo lo alto, y la atención pública y mediática es máxima.

Sólo es cuestión de tiempo que alguien denuncie correctamente y alguna autoridad dé la ¿sorpresa?.

Jorge García Herrero

Abogado y Delegado de protección de datos