Supervisión Humana Efectiva: the M-AI-nority Report

Esta semana nos lo hemos currado

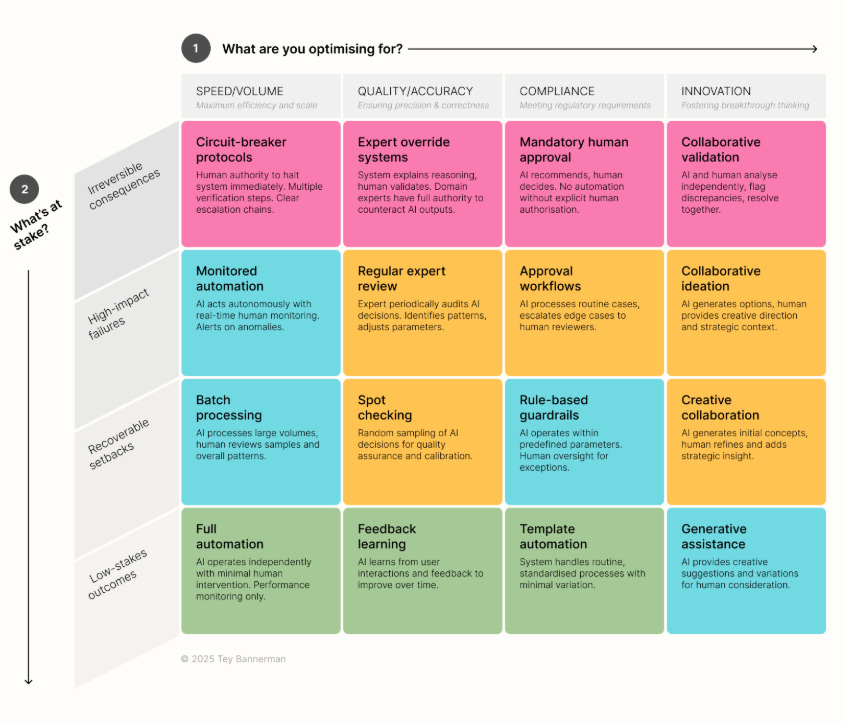

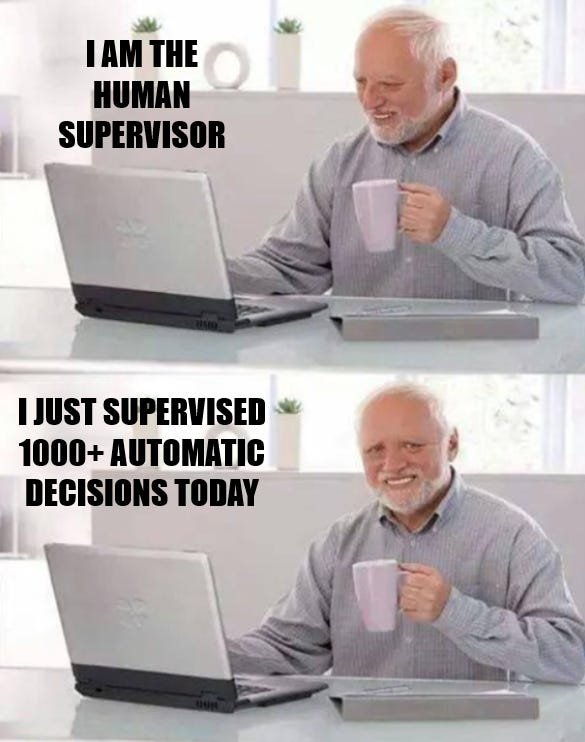

Descubrí este framework de Tey Bannerman para aterrizar en la práctica ese tópico tan cuqui del “human in the loop” en herramientas de IA y me enamoré de él:

Me resulta muy difícil abstraer de esta manera para conseguir una visualización tan precisa, práctica y útil.

Sin embargo, desde el punto de vista legal, no es exactamente correcto: el RGPD aplica ya en cuanto las decisiones automatizadas tienen “efectos significativos o jurídicos” y este factor hace que muchas más casillas deberían ser rosas.

¿Sería yo capaz de montar una infografía tan buena como ésta, pero escrupulosamente correcta desde el punto de vista jurídico?

Ni en cien años.

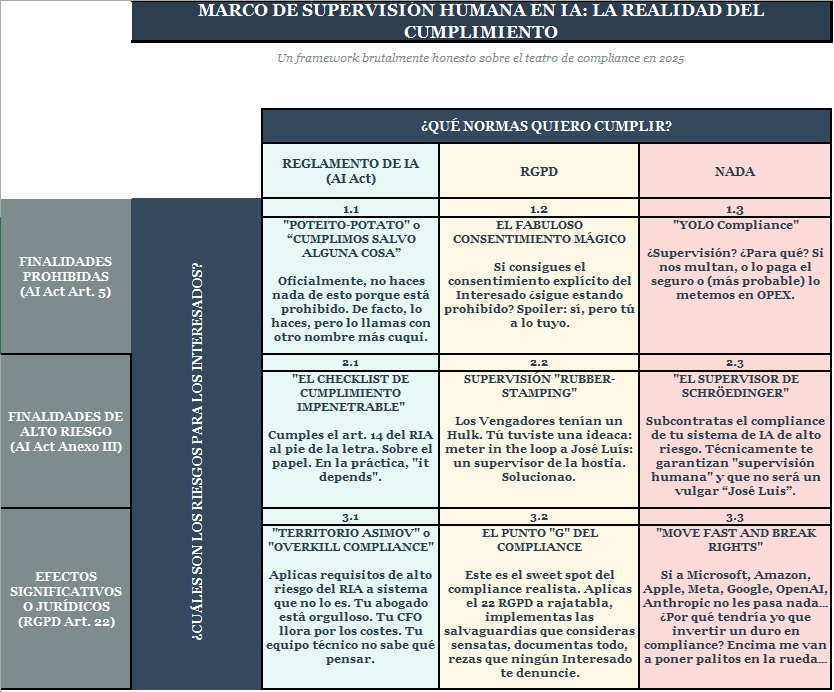

¿Podría montar una versión medio de coña, medio en serio -marca de la casa-, con ejemplos documentados y otros fácilmente reconocibles, para señalar y hacer entender los problemas del human in the loop y la supervisión humana efectiva, y el trabajo que conlleva cumplir la AI Act y el RGPD?

Aquí tienen.

Lo hemos llamado “Minority Report” porque pretende poner de manifiesto todos esos problemas que nadie comenta, y que se ven por ahí todos los días.

Somos tan pesaos que vamos a ir explicando con pelos, señales y ejemplos cada uno de los cuadrantes.

Dótense de un paquete de kleenex y un café antes de empezar.

Estás leyendo ZERO PARTY DATA. La newsletter sobre actualidad tecnológica desde el punto de vista del derecho de protección de datos e IA de Jorge García Herrero y Darío López Rincón.

En los ratos libres que nos deja esta newsletter, nos gusta resolver movidas complicadas en protección de datos personales e inteligencia artificial. Si tienes de alguna de esas, haznos así con la manita. O contáctanos por correo en jgh(arroba)jorgegarciaherrero.com

¡Gracias por leer Zero Party Data! Apúntate!

Nivel 1: FINALIDADES PROHIBIDAS (Art. 5 RIA)

Cuadrante 1.1: Prohibido + Quiero cumplir AI Act “I WANT TO COMPLY”

“Poteito-potato” o “Cumplimos salvo alguna cosa”

El sistema existe y no existe simultáneamente. Oficialmente, no haces nada de esto porque está prohibido. De facto, lo haces, pero lo llamas con otro nombre más cuqui.

Cualquier parecido con la realidad es pura coincidencia:

“No es social scoring, es un sistema de ‘evaluación integral de conducta ciudadana’ con fines de optimización de servicios públicos”.

“No es manipulación subliminal, es “arquitectura de elección basada en ciencia del comportamiento”.

Supervisión:

Un comité de ética que se reúne trimestralmente para confirmar que “técnicamente” no estás haciendo lo prohibido porque lo has rebautizado. Actas en PDF. Sólo Otter.ai hace caso a estas actas: las resume para que nadie las lea y las graba para sus propios fines.

Cuadrante 1.2: Prohibido + Quiero cumplir RGPD

“El Consentimiento Mágico”

Si consigues el consentimiento explícito del Interesado ¿sigue estando prohibido? Spoiler: sí, pero tú a lo tuyo, José Luís.

Cualquier parecido con la realidad es pura coincidencia:

Pop-up de cookies de 47 páginas que incluye cláusula 23.5.b: “Consientes el uso de sistemas de inferencia emocional basados en análisis facial para personalizar tu experiencia”

“He leído y acepto que mi comportamiento en redes sociales sea usado para calcular mi puntuación de confiabilidad crediticia” ← 0.02% de usuarios leen esto

Supervisión:

Un script generado con Claude Code revisa que la casilla de aceptación no esté pre-marcada. “Mi trabajo aquí ha terminado”.

Cuadrante 1.3: Prohibido + No quiero cumplir nada

“YOLO Compliance”

¿Supervisión? ¿Para qué? Si nos multan, o lo paga el seguro o (más probable) lo metemos en OPEX.

Cualquier parecido con la realidad es pura coincidencia:

.- Clearview AI scrapea todo Internet para en entrenamiento (y funcionamiento) de su herramienta de reconocimiento facial: “¿Supervisión? Nuestro supervisor humano es el CEO. Él aprueba todo” (Multado €20M por Garante italiano).

“Operamos desde una jurisdicción externa a la UE así que su normativa no nos aplica” Voz en off de narrador: “Sí aplicaban, mi Ciela”.

Supervisión:

El becario de legal revisa los tickets de Jira cuando le sobra tiempo. Espoiler: nunca le sobra tiempo.

Nivel 2: FINALIDADES DE ALTO RIESGO (Anexo III del RIA)

Sistemas para contratación, crédito, educación, servicios esenciales, law enforcement, biometría permitida, gestión de trabajadores, etc.

Cuadrante 2.1: Alto riesgo + Quiero cumplir AI Act

“El Checklist de Cumplimiento impenetrable”

Cumples el art. 14 del RIA al pie de la letra. Sobre el papel. En la práctica, la cosa cambia.

Requisitos del Art. 14:

· Competencia para entender las capacidades y limitaciones del sistema, para detectar sesgos propios (ej: el de automatización) y en el sistema, para interpretar correctamente sus outputs.

· Autoridad para no usar el sistema; para anular o revertir el output; para interrumpir su funcionamiento.

Ejemplo real:

El sistema de selección de personal automatizado de Amazon (2014-2018):

El checklist impenetrable: “Los supervisores humanos revisan recomendaciones de IA”

En la práctica: El sistema discriminó tooodos los curricula de candidatas a puestos técnicos. Nice.

Los supervisores nunca lo detectaron.

¿La tecnología era una mierda? ¡Para nada! El sistema aprendió a inferir el sexo del candidato detectando palabras que utilizan más los hombres que las mujeres, para fastidiar a éstas.

El principal problema fue que el dataset de entrenamiento incluía años y años de discriminación activa por parte de los seleccionadores humanos de Amazon en este sentido: el modelo simplemente aprendió a hacer más eficazmente lo mismo, perpetuando el sesgo.

Supervisión efectiva: Amazon abandona el proyecto en 2017 cuando no pudieron garantizar que no encontraría otros patrones discriminatorios.

No, en caso de que te lo preguntes, esto no vale como ejemplo de “kill switch”.

Lección aprendida: Un supervisor humano puede “revisar” sin “entender” durante 4 años consecutivos. Y así lo hará si no le proporcionas la formación adecuada.

Supervisión implementada (cualquier parecido con la realidad es coincidencia):

Formación para evitar el sesgo de confirmación: PowerPoint de 45 slides de ingesta obligatoria. Test posterior de 10 preguntas. Tasa de aprobación del 100% (explicación: podían repetir el test infinitas veces. Y lo hicieron. Vaya si lo hicieron).

Mecanismo de override (reversión de la decisión automatizada): La opción “Revertir recomendación IA” requiere (i) una justificación escrita de 200 palabras, más (ii) aprobación de supervisor, y (iii) un ticket en Jira.

Resultado: Tasa de override: 0.03%. ¿¿Un éxito?? Si esto ocurre en tu organización, alguien debería hacerse unas preguntas. Y quizá ese alguien seas tú.

Si están en este cuadrante, llámennos. Será un placer atenderles.

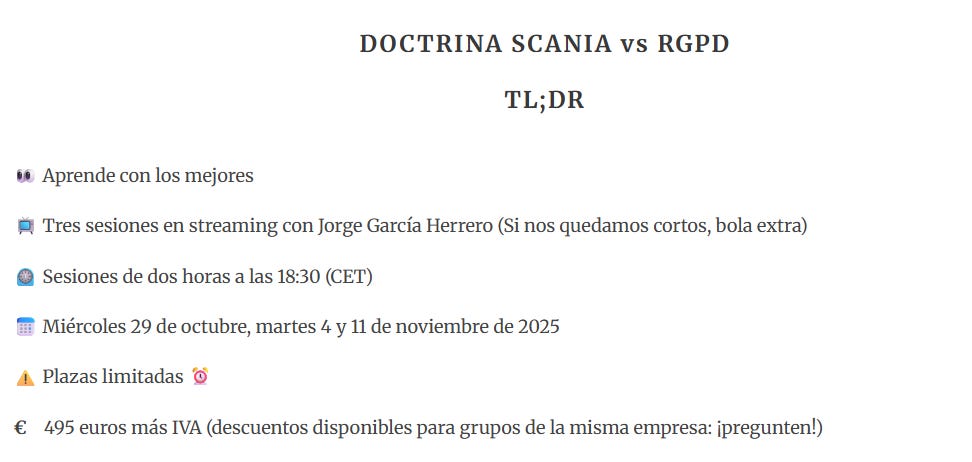

AUTOPROMO: Formación Doctrina Scania vs RGPD

En enero del 26 volveremos con nuestra formación “Aplicando el RGPD a la IA hoy” incorporando la implementación efectiva de la SHE (Supervisión Humana Efectiva) a las herramientas de IA en tu organización.

De momento y a corto plazo, desde el 29 de octubre haremos una formación corta y al grano con la aplicación de la Doctrina Scania como protagonista.

Ya sabéis: basada en casos prácticos reales y al jamón, zero bullshit.

Plazas limitadas (y ya tengo varias cubiertas). Información aquí e inscripciones escribiendo a formación(arroba)jorgegarciaherrero.com

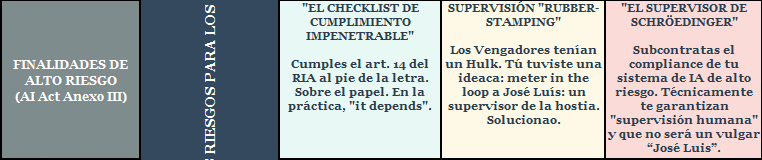

Cuadrante 2.2: Alto riesgo + Quiero cumplir RGPD

“Supervisión rubber-stamping”

“Los Vengadores tenían un Hulk. Nosotros tuvimos una ideaca”: meter in the loop a José Luís: un supervisor de la hostia, tú. Solucionao.

El art. 22 RGPD prohíbe las decisiones “basadas únicamente en el tratamiento automatizado”. Tu solución: añadir un dedo humano que hace clic en “Aprobar” como si no hubiera un mañana.

Técnicamente, ya no es “únicamente automatizado”. Los jueces lo ven de otro modo, pero el papel lo soporta todo hasta que llega la primera denuncia.

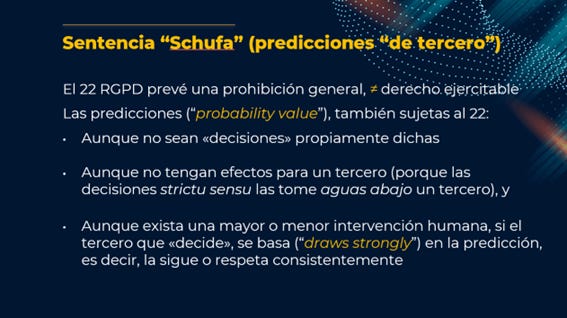

El plot-twist: la Sentencia Schufa del TJUE (C-634/21, 2023)

El caso: Schufa vende un servicio de scoring de riesgo crediticio a los Bancos. Un Banco, siguiendo el scoring de Schufa denegó el crédito a un cliente.

El cliente denunció a Schufa y al Banco.

Schufa dijo: “Yo no tomo decisiones, sólo propuestas a los bancos”.

El Banco dijo: “Yo no tomo decisiones automatizadas, cojo las propuestas de Schufa y Johannes Luisen las revisa” “¿Es que no ve este sello de goma tan grande?”.

El Tribunal de Justicia de la UE dijo: Si el banco “dependen fuertemente” (“draws strongly”) del score, es una decisión automatizada prohibida por el Art. 22 RGPD.

El sello de goma de Johannes Luisen no cuenta como “revisión humana” si sistemáticamente ratifica la propuesta automatizada.

Ejemplos de Flow de decisión ficticios: Nuuunca sucede asín en la práctica.

Caso 1 - Credit scoring:

La IA genera un score de crédito.

José Luis entra en acción: Lee el score (78/100). Ve ingresos declarados. Revisa en 30 segundos. Aprueba/rechaza. Muy bien, chaval.

El sesgo invisible: Según un estudio de la universidad de Stanford de 2021, las IAs son entre un 5 y un 10% menos precisas precisamente en los rangos de menores ingresos y de minorías (frente a individuos de mayores ingresos y WASP). José Luís no sabe nada de esto si no le forman sobre las fortalezas y las debilidades del sistema que tiene que revisar).

Comentario en la PIA de una sola línea: “Supervisión humana dirimente de acuerdo con el art. 22 RGPD“. (Choque de pechos entre el DPO y el Director de compliance a lo Villi Manilli. Nah, es broma: los dos son la misma persona.)

Caso 2 – Deliveroo y Foodinho (multas del Garante de 2,5 y 2,6 millones respectivamente)

Un algoritmo asigna turnos de trabajo a riders basándese en un scoring de desempeño.

Los managers (Giuseppe Luigi y sus amici) pueden modificar las asignaciones.

En la práctica, el sistema gestiona 8,000 riders. Los amici no tienen ni tiempo ni información suficiente como para cuestionar nada.

Garante italiano: Brillan por su ausencia la revisión sistemática de la exactitud y calidad de las decisiones (output) del sistema, así como la relevancia de los datos (input) utilizados para generar aquéllas. Adicionalmente: la necesidad contractual alegada no era aplicable (tiene que ser objetivamente necesaria: recuerden).

Supervisión implementada (cualquier parecido con la realidad es puritita coincidencia):

Diseño de la interfaz: La IA recomienda. Jose Luis ve la recomendación en pantalla grande. Ve un botón verde “Aprobar” así de grande. Ve un botón rojo “Rechazar”. Al pincharlo se despliega un menú de 15 razones posibles y un campo de texto libre a cumplimentar con 300 palabras, como antes.

KPIs relevantes:

El que cuenta en la organización: “Decisiones procesadas por hora”.

El que el DPO propone introducir en la PIA “% de precisión de decisiones” o “Tasa de detección de sesgos del sistema”.

El que realmente se documenta: ninguno.

The lethal legal trifecta:

Sesgo de automatización +diseño de interfaz complaciente+ KPIs perversos = rubber stamping a degüello.

Si están en este cuadrante (ojo: y quieren mejorar), llámennos. Será un placer atenderles.

Cuadrante 2.3: Alto riesgo + No quiero cumplir nada

“El Supervisor de Schrödinger”

Subcontratas el compliance de tu sistema de IA de alto riesgo. Técnicamente te garantizan “supervisión humana” y que no será “José Luis, el NPC”.

Y efectivamente: tu Supervisor trabaja en Bangalore. “Revisa” 300 casos/hora en una pantalla de 13 pulgadas. No habla tu idioma local. Tiene cero contexto. Tiene cero entrenamiento. Pero ¡Hey!: es humano.

Ejemplos reales documentados:

El escándalo holandés del ChildCare (2013-2021):

El algoritmo SyRI utilizado por la Agencia Tributaria y la Autoridad de Aduanas holandesas detectó erróneamente fraudes en los subsidios para el cuidado de niños en familias vulnerables.

Los datos que disparaban la “VOX de alarma” automatizada: “Apellidos que suenan a extranjero” + “doble nacionalidad” = alto riesgo de fraude.

Los supervisores sólo actuaban los casos de etiquetados como de “mayor riesgo de fraude”. En la práctica, los ratificaban en una abrumadora mayoría de los casos.

Resultado: Se reclamó la devolución de las ayudas a más de 26,000 familias (que, recuerden, las habían recibido por estar en riesgo de exclusión social). Las cantidades exigidas superaban decenas de miles de euros por familia, sin posibilidad de aplazamiento.

Más de 1,100 niños fueron separados de sus familias y quedaron bajo tutela estatal.

El Gobierno Holandés dimitió en enero de 2021 como consecuencia del escándalo. El presidente, Mark Rutte lidera la OTAN nowadays.

Fun-fact: La abogada que consiguió hacer saltar por los aires este desgraciado tinglado no se llamaba Erin Brokovich, sino Eva González Pérez: es española.

Ah, the irony!: En el año de nuestro señor de 2025, un gobierno formado por los mismos partidos promueve la implementación de otro sistema (no lo adivinarían ni en cien años: se llama Super-SyRI”) que pretende combinar datos de distintas administraciones para prevenir y combatir los delitos graves. Buena suerte con eso.

Gobernanza acusica en Instagram/Threads (Octubre 2024):

Meta modera contenidos mediante IA. Lo supervisores humanos revisan cuando hay dudas.

¿Qué decía la PIA? “Los moderadores humanos toman las decisiones con muuucho contexto”.

Yes But: Una de las herramientas cascó y dejó de mostrar contexto a moderadores. Un montón de usuarios perdieron el acceso a sus cuentas, un montón de posts fueron borrados for no reason.

¿Qué hizo Meta?: Para sorpresa de nadie, culpar a los moderadores humanos por tomar decisiones sin contexto suficiente.

Moral crumple zone

El hecho de endilgarle el mochuelo al supervisor humano cuando el sistema de IA falla ya tiene hasta nombre: “Moral crumple zone” (Autora: Madeleine Clare Elish).

Mi traducción libre:

El énfasis en la supervisión humana como mecanismo de protección permite a gobiernos y proveedores de IA hacer dos cosas incompatibles simultáneamente: (i) promocionar una IA -porque sus capacidades superan las de los pobres mortales-, y a la vez (ii) sustraer a la IA y a su proveedor de su obligación de accountability, poniendo el peso sobre la seguridad que -sobre el papel- proporciona la supervisión humana.

Nivel 3: EFECTOS SIGNIFICATIVOS O JURÍDICOS SOBRE PERSONAS (RGPD Art. 22)

Sistemas que no son alto riesgo AI Act, pero tienen efectos legales o significativamente similares según RGPD.

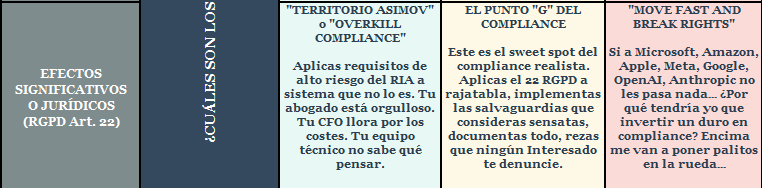

Cuadrante 3.1: Efectos significativos + Quiero cumplir AI Act

Tipo de supervisión: “Overkill Compliance”

Aplicas requisitos de alto riesgo del RIA a sistema que no lo es. Tu abogado saca pecho palomo. Tu CFO llora por los costes. Tu equipo técnico no sabe qué pensar.

Esto sí es ciencia-ficción:

Sistema de recomendación de contenido en TV por streaming: Aplicas Art. 14 RIA full equip, con su DPIA, conformity assessment. Con todo. Hasta una FRIA haces.

En la práctica: Probablemente sea una finalidad de bajo riesgo de acuerdo con el RIA, pero podría tener “efectos significativos” según el RGPD -Exponendo 71-. Lo sé: muy pillado por los pelos.

Resultado: Eres el unicornio del compliance. Te invitan a todos los congresos. Te despiden en diciembre.

Supervisión implementada:

Comité de supervisión humana con 7 miembros

Reuniones semanales

Dashboard en tiempo real de métricas de oversight

Documentación exhaustiva de cada “override”

Budget anual: €450.000

Sistema: Recomienda películas

Riesgo real: Bajo

Señalización de virtud (Virtue signalling”): Top

No nos llamen si están aquí. De hecho, no hay nadie aquí.

Cuadrante 3.2: Efectos significativos + Quiero cumplir RGPD

“El punto G del compliance”

Este es el sweet spot del compliance realista. Aplicas el 22 RGPD a rajatabla, implementas las salvaguardias que consideras sensatas, documentas todo, rezas para que ningún Interesado te denuncie.

Cualquier parecido con la realidad es pura coincidencia:

Caso típico de empresa promedio:

Tus clientes interactúan con un AI chatbot (últimamente, un AI Agent) que tiene acceso a todos sus datos.

Supervisión: un numeroso equipo de supervisores integrado por dos personas, revisan decisiones y resuelven reclamaciones.

En la práctica: el 0.001% de clientes piden revisión. Se cambian el 0% de las decisiones porque “¿Quién soy yo para llevar la contraria a esta IA tan cara?”.

Comentario en la PIA de una sola línea: “procedimiento de supervisión humana dirimente de acuerdo con el art. 22 RGPD”. ✅

Compliance real: 🤷 Nadie lo usa, nadie lo testea.

Supervisión implementada en la realidad:

El apartado 56 de tu política de privacidad explica “cómo funciona nuestro algoritmo” en 1.800 palabras llenas de generalidades.

Proceso de reclamación: Email a compliance@company.com. Respuesta automatizada: “Hemos recibido su solicitud: se revisará en 30 días”

En la práctica: Analista junior estudia el caso durante cinco minutos. No tiene información sobre el funcionamiento del sistema. Observa el output. Observa el input. Rechaza apelación pulsando un botón verde así de grande.

Tasa de reversión de decisiones tras apelación: no se registra.

“Técnicamente cumplimos”

Si están en este cuadrante, llámennos. Será un placer atenderles.

Cuadrante 3.3: Efectos significativos + No quiero cumplir nada

Tipo de supervisión: “Move Fast and Break Rights”

Si a Microsoft, Amazon, Apple, Meta, Google, OpenAI, Anthropic no les pasa nada… ¿Por qué tendría yo que invertir un duro en compliance? Encima me van a poner palitos en la rueda…

“Primero conquistamos territorio”, y después que venga el chupatintas a hacer los papeles si toca en la puerta la AEPD.

Ejemplos reales documentados:

Sistema de concesión pocha de hipotecas Wells Fargo (2022):

El sistema daba scores de riesgo más altos a candidatos negros y latinos que a los blancos con finanzas similares.

Revisión humana de decisiones automatizadas: Supervisores humanos “revisaban” solicitudes. El problema es que, si el sistema está sesgado y los supervisores no desafían sus decisiones, el sesgo se perpetúa (véase “Moral crumple zone” más arriba”).

¿A alguien se le ocurrió medir la disparidad de tasas de aprobación por raza? Sí, pero sólo cuando la autoridad inició su investigación.

Tsunami de AI Agents (2025):

Todo tipo de empresas desplegando AI agents para servicio al cliente, programación, distintos tipos de análisis…

Una sola línea en la PIA: “Human in the loop para decisiones con efectos significativos”.

En la práctica: ¿Definición de “decisiones con efectos importantes”? It depends. En el mejor de los casos, la supervisión consiste en una revisión post facto de un porcentaje ínfimo de casos.

Caso para las charlas de formación: La IA de un Taco Bell (un drive-through para coches) aceptó -sin, je, pestañear- un pedido de 18,000 botellines de agua.

Supervisión implementada:

Monitoring dashboard con métricas técnicas (latency, throughput, error rate)

Nada de métricas de impacto en interesados

“Human oversight” = Intervención de un ingeniero a demanda cuando el sistema casca.

El sistema aprende de sus errores. Los errores son features, not bugs. Los Interesados son beta testers no remunerados.

Si te ha gustado Zero Party Data, compártelo, no seas asín.