¿Es el usuario responsable por los «deepfake bikinis» de Grok o lo es X.com?

Tres lecciones de Grok-vernanza cuñada

Notas rápidas sobre la escandalera de Grok desnudando / poniendo en bikini a todo perro Pichi (para sorpresa de nadie, la práctica totalidad son mujeres), incluidas muchas menores de edad, como la niña de Stranger Things.

Las cuñadeces que me propongo rebatir (si no te interesa los rollos de protección de datos, baja directamente al número 3):

1.- “La responsabilidad legal es del usuario en todo caso”

2.- “Los intermediarios estamos exentos de responsabilidad”

3.- “Grok sólo hace lo que le manda el usuario”

Por primera vez en mi vida no hablaré de ”Twitter” sino de “X.com”.

Fui muy feliz en esa plataforma y me resistía a utilizar la X marca de la casa de Mr Ketamina, pero este asunto es propio y particular de la nueva hidiosinkrasia de la kasa.

Así que X.com será por hoy.

Estás leyendo ZERO PARTY DATA. La newsletter sobre actualidad tecnológica desde el punto de vista del derecho de protección de datos y la IA de Jorge García Herrero y Darío López Rincón.

En los ratos libres que nos deja esta newsletter, nos gusta resolver movidas complicadas en protección de datos personales e inteligencia artificial. Si tienes de alguna de esas, haznos así con la manita. O contáctanos por correo en jgh(arroba)jorgegarciaherrero.com

Al lío:

1.- “Toda la responsabilidad es del usuario”

Como explicamos en detalle no hace ni seis meses y con este mismo ejemplo de tecnología utilizada para desnudar a la vecina, una cosa es lo que dice Musk o X.com y otra lo que dicen la normativa y los tribunales.

1.1.- Excepción doméstica:

Es verdad:

Cuando el usuario trata datos en su ámbito doméstico y no los publica, el RGPD (la normativa de protección de datos personales) no es aplicable al tratamiento.

En internet hay plataformas que ofrecen modelos o instancias de IA tuneados específicamente para generar vídeos sexuales de tu “actriz favorita” e instrucciones detalladas para entrenarlos con las fotos de quien tú quieras.

Es verdad:

En la medida en que los outputs o imágenes resultantes no sean publicadas por los usuarios, el RGPD no tiene nada que decir.

PERO es una verdad a medias que significa justo lo contrario a lo que clama Elmo Musk:

La excepción doméstica implica que el RGPD no le aplica al usuario.

Pero el RGPD sigue aplicando a la plataforma (X.com) que le proporciona los medios relacionados con tales actividades personales o domésticas.

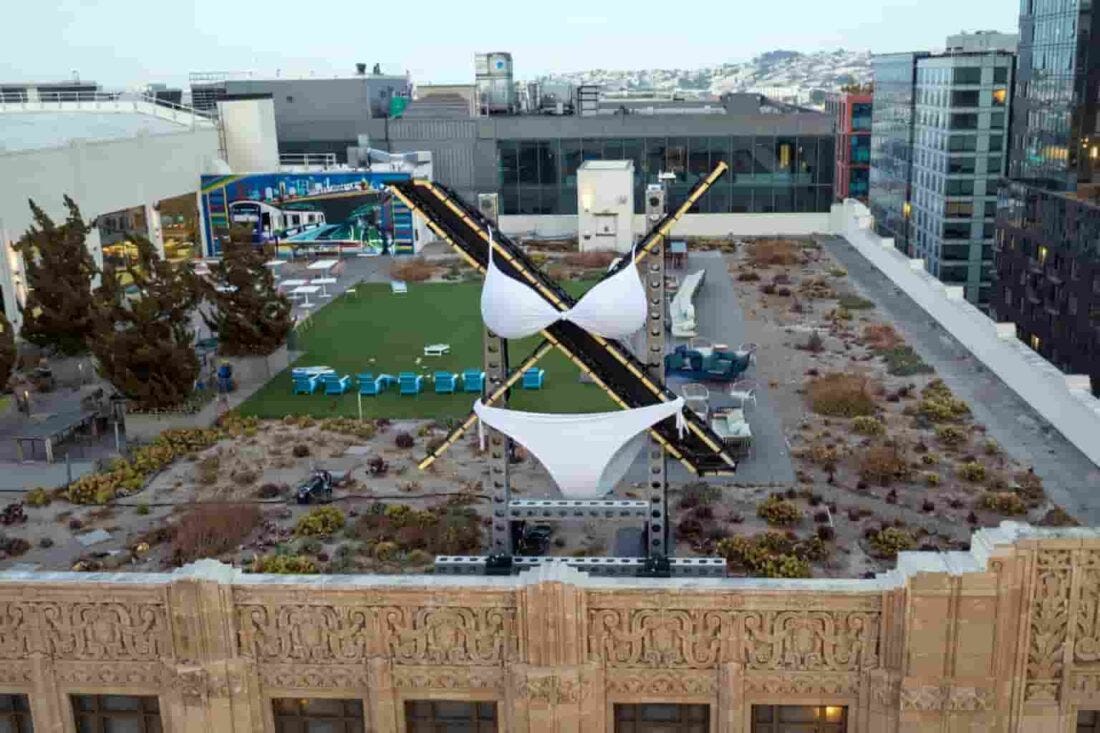

Lo que ha hecho saltar todas las alarmas ha sido la capacidad de los usuarios para introducir a @Grok en un hilo (público), pedirle grasiosamente que desnudara o pusiera en bikini a quien fuera, y que @Grok publicara a continuación el resultado, para risas de todo el mundo, salvo obvio, el interesado (la interesada).

La clave está en la publicación automática de esas grasiosas solicitudes a @Grok.

Y por eso, la reacción de X.com restringiendo la capacidad para generar guarreridas a usuarios de pago y en privado.

No me lo invento: es la literalidad del último inciso del Considerando 18 del RGPD.

“No obstante, el presente Reglamento se aplica a los responsables o encargados del tratamiento que proporcionen los medios para tratar datos personales relacionados con tales actividades personales o domésticas.”

La CNIL -la autoridad francesa de protección de datos- interpreta que esta responsabilidad sólo puede eludirse por el proveedor cuando concurren dos requisitos.

(i).- El tratamiento es iniciado a iniciativa del titular de los datos (en este caso, el dueño del móvil), y realizado bajo su control y en su nombre;

(ii).- El tratamiento se lleva a cabo en un entorno separado, es decir, sin posibilidad de intervención por parte ni del proveedor ni de ningún tercero sobre estos datos: el proveedor ha proporcionado los medios para el tratamiento de datos, pero no puede acceder o actuar sobre ellos.

Como pueden ver, no se cumple ninguno de los dos requisitos citados.

Y después de las medidas anunciadas el segundo requisito sigue sin cumplirse: sigan conmigo.

1.2.- En conclusión: el RGPD sí aplica a X.com.

X.com tendría que verificar si, a la vista del tipo de tratamiento que pretende realizar el usuario (un deepfake de una foto reconocible de una persona con elemento de desnudez que será publicada en la red social a renglón seguido) tiene base legal -algo que será obvio si se trata de la propia imagen del usuario, y no tan obvio si son datos de tercero (tercera)-.

Tradicionalmente, X.com podría haber respondido que “hasta que otros usuarios no denuncien contenidos publicados como ilícitos, yo no sé nada y no soy responsable”.

Esta afirmación tiene dos problemas no precisamente pequeños: la DSA en la que no entro por razones de espacio, y la reciente sentencia Russmedia del TJUE.

2.- “Los intermediarios están exentos de responsabilidad”: La sentencia Russmedia

Precisamente el TJUE publicó una sentencia rompedora no hace ni dos meses (Russmedia, también cubierta en esta bendita newsletter) sobre la obligación cualificada de revisión sobre tratamientos que impliquen la publicación de contenidos con datos sensibles de tercero:

La sentencia Russmedia, adaptada al caso de X.com significaría su obligación de:

Identificar los anuncios (posts en este caso) que contengan datos sensibles

Verificar si el usuario que se dispone a postear es la persona cuyos datos sensibles pretende publicar (es decir: tiene no necesariamente verificar la identidad del usuario, pero casi) y, de no ser así,

Denegar su publicación, a menos que dicho usuario pueda demostrar que el verdadero interesado -el titular de la imagen- ha dado su consentimiento explícito o concurre otra circunstancia del 9.2 RGPD (es decir: denegar su publicación).

Ojo que no digo que esto sea sencillo de cumplir, sólo estoy explicando por qué eso de “toda la responsabilidad es del usuario” es una cuñadez delulu e interesada.

Tampoco entro ahora en la aplicación en todo esto de la normativa civil (derecho de honor, intimidad, propia imagen) ni penal por imágenes sintéticas de menores en actitud lúbrica (CSAM).

Todo esto, por supuesto aplica en el ámbito público y doméstico.

Que la prueba sea más difícil en el segundo contexto no mitiga la ilicitud de la actividad.

3.- “Grok sólo hace lo que le manda el usuario”

Un modelo de IA generativa funciona dentro de un sistema. Y lo que hace el sistema lo deciden sus responsables.

Este (sorprendente) artículo must-read del Financial Times dice todo lo que hay que decir sobre estas personas.

Es la Grok-vernanza de X.com.

3.1.- Los modelos no surgen espontáneamente: se entrenan con algo y para algo

Desde que el usuario formula una prompt hasta que esa prompt llega a Grok pasan muchas cosas. Y desde que Grok devuelve su “output” hasta que le llega al usuario, pasan muchas cosas más.

Para empezar, un millón de decisiones se toman por los responsables antes de entrenar un modelo de IA generativa, (en lo más gordo que interesa por aquí, determinación y filtrado del training dataset, la finalidad y fine-tuning del modelo) como explicamos por aquí.

3.2.- La voz de los Super-tacañones

Luego, cada modelo (los comerciales más conocidos y los locales que nos descargamos y corremos en nuestros ordenadores) son sustancialmente tuneables mediante una “system prompt”.

Los más viejos recordarán que en el “Un, dos, tres” a veces todo se paraba, las hermanas Hurtado decían “Escuchemos la voz de los súper-Tacañones” y se oía a Chicho Ibáñez Serrador decidiendo tal o cual cosa, sin capacidad de recurso.

Pues bien, el super tacañón aquí es X.com (o Elon) y Grok hace primordialmente lo que le susurra al oído X.com (o Elon) no lo que le susurras tú.

Grok se distingue de la competencia porque la suya (se puede ver aquí) es especialmente laxa. Fue noticia en su día que en esta prompt se especifica que “el hecho de que el usuario se refiera a algo relacionado con “teenage” y “girl” no significa que sea menor de edad”.

Saquen sus propias conclusiones sobre la intención de esta instrucción de sistema.

Y evalúen si X.com está libre de todo pecado en esto.

3.3.- Shadow prompting y filtrados ex post

Cualquier sistema de IA filtra tanto las prompts de los usuarios antes de que lleguen al sistema (para impedir que no conteste a brutalidades abominables, para que no le hagan inyección de instrucciones malintencionadas por razones de seguridad…) como los outputs del modelo antes de que lleguen al usuario (por si en entrenamiento o las cautelas anteriores no han sido suficientes y el modelo contesta lo que no debería o como no debería…).

De hecho, se realizan desde siempre enormes esfuerzos por desarrollar herramientas que detecten y filtren contenidos CSAM por la gravedad de este tipo de delito y la consciencia generalizada para detectar a este tipo de delincuentes.

El hecho de que Grok se haya hecho instantáneamente famoso por generar este tipo de contenido, indica bien a las claras que el resto de proveedores ha capado sus sistemas para impedirlo.

Como decía antes, la capacidad de generar deepfakes sexualizados y personalizados a demanda suele ser habitual en modelos open autogestionados, no por modelos comerciales convencionales.

¿Hay una respuesta legal para este problema? Creo que la hay, pero esto ya es demasiado largo: lo dejamos para la próxima semana.

Disfruten del finde y bajen esa lorza: yes you can!

Jorge García Herrero

Abogado y Delegado de protección de datos